【CVPR2022】用于域适应语义分割的域无关先验

摘要:本文给大家分享一篇我们在CVPR 2022 上发表的paper:Domain-Agnostic Prior for Transfer Semantic Segmentation。文章提出了一种图像域无关的先验,可以有效地提升域适应语义分割的精度。

本文分享自华为云社区《EI盘古研究分享【CVPR2022】用于域适应语义分割的域无关先验》,作者:198808xc。

1. UDA 分割中的相似类别混淆问题

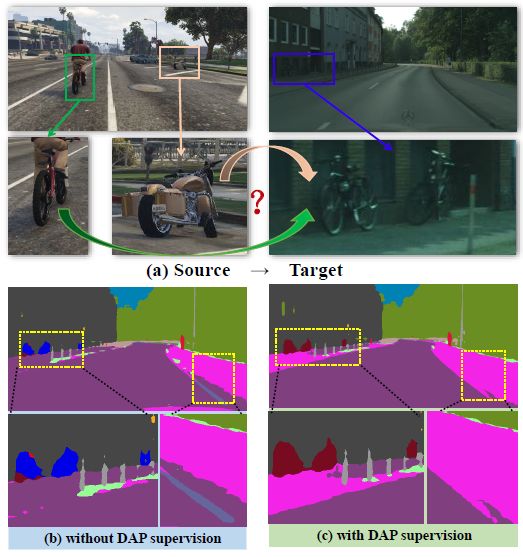

尽管self-training在UDA任务上取得不错的结果,但是在区分语义上相似的类时仍然存在困难,特别是当这些类在目标域中并不频繁出现时,例如摩托车只占总像素数的0.1%。图1给出了摩托车类对和自行车类对容易混淆的例子,道路类对和人行道类对也容易混淆。对于上述现象,我们提出了一个假设。由于来自目标域的数据,,没有标记,因此通过将映射到源域来学习语义对应,例如,通过基于GAN的图像级风格转移和通过伪标签模拟。这可以看做以一种弱监督的方式学习域适应函数。这导致近似的视觉表征,从而导致识别的不准确性。此外,我们对不同方法中的相似类别的特征进行了统计分析,表1列举了两组易混淆类别。可以看到在只有源域数据训练时,源域中相似类别虽然距离较近但是分布紧凑重叠较少,但是直接用这个模型统计目标域特征发现他们的重叠比较严重,一个经典的方法DACS[x],在引入ClassMix对两个域的图像进行混合操作后缓解了重叠的问题。

表1 两组相似类比的特征统计

图1 域适应过程混淆例子

2. 方法

2.1 基线方法DACS

在mean-teacher训练框架下为目标域图像生成伪标签,然后用目标域和源域数据一起训练网络是一种常用的方法,在此基础上,DACS[1]提出用混合域M的训练数据替换来自目标域的训练数据。混合域M的训练数据生成过程:在每次训练迭代中,对带有(真或伪)标签的源图像和目标图像进行采样并裁剪成相同的分辨率。接下来,从源域标签中随机选择一个类子集,并得到一个与图像相同大小的二进制掩码,属于选中类别的位置为1其他为0,再根据此掩码将源域和目标域数据混合在一起。

2.2 为UDA分割任务提供域无关先验

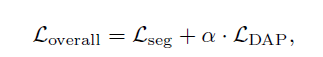

为了获得对目标域特征更准确的估计,我们参考贝叶斯理论,后验分布由先验和似然组成。在我们的设置中,似然来自目标数据集,没有足够的数据来保证准确的估计。解决方案是为每个类别引入信息先验,这些先验和域无关也不会受域差异的影响。我们找到两种先验,一种是one-hot编码,另外一种借助word2vec[2]来为每个类别生成编码。这样每个类别都有一个先验编码向量,然后根据每个图像的标签,按位置替换为先验编码,构成一个先验编码图,如图2。然后我们将其和网络提取的是视觉特征进行约束。为了让视觉特征更多保留和类别语义相关的信息减少域相关的信息,二者通过简单转换后用L2 loss拉近。这就是我们新引入的DAP loss。

该损失函数与DACS的分割交叉熵函数相加构成完整的训练过程。

图2 先验编码图构成过程

2.3 一些思考

据我们所知,这是第一个将文本编码嵌入到UDA分割的工作,并产生了相当大的准确性增益,这证明了语言线索协助视觉识别的有效性。然而,这还只是一个初步的解决方案,还可以发现一些可能的方向

1)加强文本嵌入。目前使用的word2vec的特点是它不考虑同一个语义对应不同的单词。我们试图通过搜索语义相似的单词来增强先验,但获得的准确性几乎没有提高。这可能需要探索文本世界的复杂机制。

2)构建领域不可知论但视觉感知的先验。这就回答了一个问题:什么样的图像数据被认为可以提供域无关信息? 答案可能存在于广义数据集,如ImageNet[3]或Conceptual Captioning [4],或甚至预先训练的图像文本模型,如CLIP[5]。这可能是解开领域相关的信息以避免过度拟合的一个主要挑战,值得我们继续探索下去。

3. 实验结果

3.1 数据和设置

我们在常用的街景分割场景中进行评估,将信息从合成域迁移到真实域。GTAv和SYNTHIA作为复合域数据集,Cityscapes作为真实域。为了与其他方法保持一致,我们使用Deeplabv2框架下RseNet101基本模型作为我们的图像编码器,ASPP分类器作为输出层。

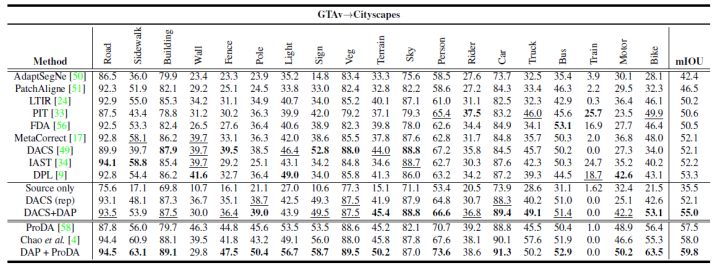

3.2 GTAv迁移到Cityscapes

我们首先在从GTAv到Cityscapes的域适应分割任务上评估DAP。DAP在19个级别上达到55.0%的平均IOU,这个结果超过基线2.9%,也优于其他单阶段和单模型训练的方法。我们将DAP的输出作为伪标签输入ProDA的第1阶段,然后保持ProDA[6]第2和第3阶段训练方法不变。我们将结果提升了2.3%,是目前最高的精度。

图4. GTAv迁移到Cityscapes结果比较。

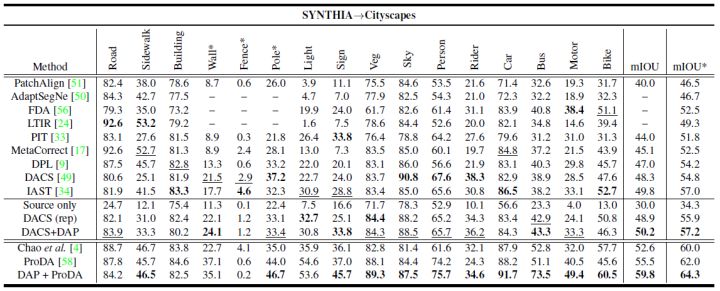

3.3 SYNTHIA迁移到Cityscapes

将SYNTHIA转移到Cityscapes的结果,如表所示,同样比DACS在13类和16类上均提升了1.3%,比ProDA提升了4.4%和2.3%。再次验证了我们方法的有效性。

图5. SYNTHIA迁移到Cityscapes结果比较。

3.4 DAP对于易混淆类别的辨别

在GTAv到Cityscapes迁移实验中,自行车和摩托车的细分iou分别从42.6%、25.1%提高到53.1%、42.2%。从SYNTHIA到Cityscapes,这两个类别平均提升2.4%。我们在图6中可视化了一个分割的例子。除了定性观察自行车与摩托车、道路与人行道的区分改善之外,我们还注意到这一改善背后的原因是这些易混淆类别的特征分布得到改善。这与表1中显示的统计数据一致,表明DAP减少了自行车和摩托车的估计分布以及道路和人行道之间的IOU。

图6. GTA迁移到Cityscapes实验中自行车和摩托车分割结果对比,以及特征分布对比。

4. 结语

到这里我们的文章就分享完了,论文中还有更详细的消融实验来证明我们方法的有效性,就不在这里详细列举,更多内容欢迎关注我们的原文。

论文:https://arxiv.org/abs/2204.02684

参考文献

[1] Wilhelm Tranheden, Viktor Olsson, Juliano Pinto, and Lennart Svensson. Dacs: Domain adaptation via crossdomain mixed sampling. In Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, pages 1379–1389, 2021.

[2] Tomas Mikolov, Ilya Sutskever, Kai Chen, Greg S Corrado, and Jeff Dean. Distributed representations of words and phrases and their compositionality. In Advances in neural information processing systems, pages 3111–3119, 2013.

[3] Jia Deng, Wei Dong, Richard Socher, Li-Jia Li, Kai Li, and Li Fei-Fei. Imagenet: A large-scale hierarchical image database. In 2009 IEEE conference on computer vision and pattern recognition, pages 248–255. Ieee, 2009.

[4] Piyush Sharma, Nan Ding, Sebastian Goodman, and Radu Soricut. Conceptual captions: A cleaned, hypernymed, image alt-text dataset for automatic image captioning. In Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), pages2556–2565, 2018.

[5] Alec Radford, Jong Wook Kim, Chris Hallacy, Aditya Ramesh, Gabriel Goh, Sandhini Agarwal, Girish Sastry, Amanda Askell, Pamela Mishkin, Jack Clark, et al. Learning transferable visual models from natural language supervision. arXiv preprint arXiv:2103.00020, 2021.

[6] Pan Zhang, Bo Zhang, Ting Zhang, Dong Chen, YongWang, and Fang Wen. Prototypical pseudo label denoising and target structure learning for domain adaptive semantic segmentation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 12414–12424, 2021.

|

- 上一条: WasmEdge 邀请你参加 Open Source Summit NA | 活动预告 2022-06-20

- 下一条: 分布式事务处理方案大 PK! 2022-06-20

- 后端工程师的「跨域」之旅 2022-01-04

- 全卷积网络(FCN)实战:使用FCN实现语义分割 2022-03-18

- 前后端分离项目,如何解决跨域问题? 2022-02-24

- 跟我读CVPR 2022论文:基于场景文字知识挖掘的细粒度图像识别算法 2022-04-24

- 移动域全链路可观测架构和关键技术 2022-03-11